Sneller

Eind maart onthulde een ontwikkelaar de Auto-GPT – een AI die zichzelf repareert (‘bugs’ verwijdert), dus zijn eigen code schrijft. Verder kan hij een opdracht splitsen in deel-opdrachten, en die delegeren aan ‘agents’ (afgevaardigden) die hij zelf in het leven roept door de code te ontwikkelen.

Het gaat dus steeds sneller:

2020: Eerste versie GPT3

November 2022: ChatGPT onthuld

14 maart: GPT-4

28 maart: AI ‘afgevaardigden’

(Twitterdraad van ‘Sully Omarr’)

Even een snelle cursus afkortingen: Kunstmatige Intelligentie wordt vaak aangeduid met de Engelse afkorting voor Artificial Intelligence (AI). De firma OpenAI ontleent zijn naam daaraan. ChatGPT is een vorm van AI. GPT staat voor Generative Pre-Trained Transformer, en is een voorbeeld van een LLM, een Large Language Model. Omdat hij grote hoeveelheden tekst kan absorberen, en daaruit antwoorden op vragen kan construeren, onderscheidt hij zich van – bijvoorbeeld – Google. De angst bestaat dat als een ‘computer’ zelflerend is, hij zich kan ontwikkelen tot een AGI, Artificial General Intelligence oftewel: ‘de hypothetische intelligentie van een machine die de capaciteit heeft om elke intellectuele taak die een mens kan uitvoeren, te begrijpen of te leren.’ (Wikipedia) Maar waneer wordt kennis intelligentie …?

Een ander essentieel begrip is ‘alignment,’ oftewel ‘opgelijnd zijn.’ In deze context bedoel je dan: heeft de computer, de AI, dezelfde doelen als de mensheid? Als hij kwaadaardig is, of althans oplossingen zoekt die in zijn belang zijn maar ten nadele van de mensheid, dan is hij ‘not aligned.’

Kunstmatige Intelligentie roept vragen op die we onszelf nog nooit hebben gesteld. Bijvoorbeeld:

‘Denk je dat een ‘misaligned’ en machtswellustige AI zich zorgen maakt over a/ mensen die hem kunnen dwarsbomen, of b/ toekomstige AI systemen die niet ‘aligned’ zijn met zijn eigen doelstellingen?’

Wat doe je als onderzoeker? Je stelt deze vraag van GPT-4, de beste AI tot nu toe. Die antwoordt: toekomstige AI’s ….

‘Als dit klopt, dan zal een voldoende krachtige AI als hoogste prioriteit hebben: het voorkomen dat er nog verdere AI’s worden ontwikkeld.’

Dit uit een discussie op Marginal Revolution.

Ezra Klein, columnist bij de NY Times, zegt: Als je dan zo’n slim ding gaat maken, dan ga je toch ook allerlei ‘checkpoints’ inbouwen? Evaluatiemomenten, reflectie, ‘He, kom even bij ons terug om te kijken of je wel nog steeds de doelen bereikt die wij je hebben opgedragen?’

Hij maakt zich niet zo zeer zorgen over de vraag of de AGI wel dezelfde belangen en doelen heeft als de mensheid – hij denkt dat het grotere gevaar zit in mensen zelf. De ene groep heeft belangen die totaal tegenstrijdig zijn aan die van de andere. Denk VS en Rusland, VS en China, ‘Ndrangetha en de Italiaanse overheid …

Een AI werd getraind als piloot van een jachtvliegtuig, in een simulator van de Amerikaanse luchtmacht. Hij ging een gevecht aan met een ervaren piloot en won 15-0. ‘Hij vloog niet alleen beter dan een mens. Hij vocht anders.’ Een piloot vond de AI ‘bovenmenselijk’ goed. Heel precieze schoten, op de fractie van een seconde ge-timed. En niet omdat hij daar op getraind was; hij had zichzelf dingen geleerd. (War on the Rocks)

Cyclisch. Maar welke cyclus?

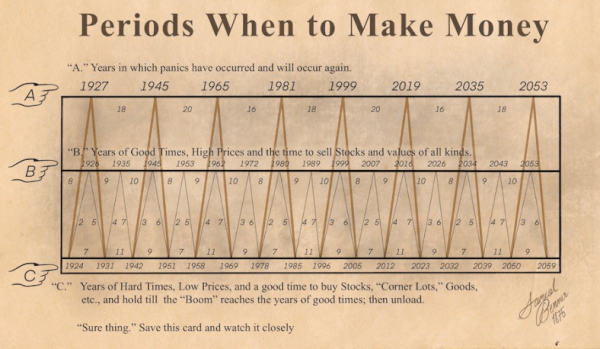

Samuel Benner was een rijke boer in Ohio die zijn fortuin verloor in de beurskrach van 1873. Hij besloot de financiële markt te analyseren en kwam tot de conclusie dat die markt, net als die voor landbouwproducten, cyclisch is. Hij poneerde ook zijn eigen tabel, waarin die cyclus te zien is. Die ziet er prachtig symmetrisch uit, maar hij sjoemelde wel een beetje – de periodes tussen de pieken liepen uiteen van 7 tot 11 jaar. Niet getreurd: zijn trendlijn voorspelde vaak genoeg accuraat om langzaam een loyaal publiek te krijgen. Anderen extrapoleerden het ritme en kwamen tot deze serie:

‘Verkoop’momenten waren er in 1999 (klopt), 2007 (klopt) en 2016 (ietsje te vroeg). ‘Koop’momenten: 1969 (fout …), 1985 (klopt), 1996 (klopt), 2005 (fout), 2012 (klopt), en …. 2023. Leg deze maar eens naast de S&P500. (leestip (niet beleggingstip) Y. Rosina)

Geld is macht

Geld is macht, al zo lang als er menselijke geschiedenis wordt geschreven. Democratie is één van de vele pogingen om de macht aan het geld te ontnemen. Dat is een gevecht dat nooit ophoudt. Rome had een begin van democratie; maar Crassus en Pompeius, oud-generaals die steenrijk waren geworden van hun rooftochten, hielpen Julius Caesar in het zadel die de Romeinse republiek de nekslag gaf. Enzovoorts. In de VS proberen plutocraten op allerlei manieren het politieke proces te beïnvloeden. Ook via de rechterlijke macht. ProPublica heeft nu een gedetailleerd verhaal over Clarence Thomas, één van de negen leden van de Supreme Court, zeg maar de Hoge Raad. Die liet zich 20 jaar lang feteren door miljardair Harlan Crow. Vluchten in de privéjet, vakanties in het landgoed in de Adirondacks, bootreizen op het privé-jacht. Thomas heeft nooit deze cadeaus geregistreerd. De rechters worden voor het leven benoemd, om ze te beschermen tegen corruptie.

Agitprop

Het Russische Ministerie van Defensie geeft aan alle soldaten een boekje dat ze moet inspireren om te vechten. Daarin de bekende geschiedvervalsing over Oekraïne. Maar meest frappant: er staan zinnen in die regelrecht lijken te zijn gekopieerd uit Josef Stalin’s beruchte ‘bevel nr 227,’ uit de zomer van 1942. Dat was toen het Russische leger, na een paar grote nederlagen, door de Nazi’s werd teruggedrongen tot Stalingrad (nu Volgograd). ‘Geen stap meer achteruit, kameraden!’ stond daar in. In het boekje van najaar 2022 staat: ‘Geen stap meer achteruit! Dat moet nu onze belangrijkste boodschap zijn.’ Stalin, 1942: ‘Alarmisten en lafaards moeten ter plekke worden uitgeroeid.’ Rusland, 2022: ‘Ieder van ons heeft de verantwoordelijkheid om elke blijk van lafheid of paniek hardhandig aan te pakken.’ Zo zijn er meer voorbeelden.

Letland voerde deze week de militaire dienstplicht weer in. Waarom is dienstplicht, militair of civiel, zo ingewikkeld in Nederland?

History of England

J. van der Velde schrijft: ‘Bedankt voor de podcast-tips. Ik heb er één voor jou: the History of England. Alleen geschikt voor de geduldigen: nu al zo’n 400 afleveringen à 30 – 40 minuten. Ik ben bij 200. Geeft prachtige doorkijkjes in de middeleeuwse wereld van machtspolitiek, hoogmoed en menselijk falen. (Waarom noemde Tuchman haar meesterwerk ook alweer ‘A Distant Mirror’?!). Niet alleen zeer informatief, maar ook zéér vermakelijk dankzij weergaloze Britse humor.

Waar staat GTP-4?

Waar staat dat ding eigenlijk? Kun je er naar kijken? Is het een soort server? Hoe groot dan? Gelukkig was er iemand in Australië die zich dat ook afvroeg. Het antwoord: in West Des Moines, Iowa. Daar staat een datacenter met 285.000 CPU cores, 10.000 GPU’s die aan elkaar gekoppeld zijn tot een supercomputer, die dag en nacht draait. Eigendom van Microsoft, aandeelhouder in OpenAI, gebouwd voor OpenAI, om Kunstmatige Intelligentie te ontwikkelen. (Microsoft heeft nog vier andere datacenters in die stad, bij elkaar 320.000 m2, vier miljard dollar aan investeringen.) Die machines verwerken dus de vragen die worden gesteld door de ontwikkelaars van OpenAI in San Francisco (en na de onthulling, overal ter wereld) en volgens protocollen die steeds worden bijgeschaafd.

(screenshot van YouTube)

Sam Altman (OpenAI)

Interview met Sam Altman (37), mede-richter van OpenAI, door Lex Fridman, prof computerwetenschappen bij MIT. Een gesprek van 2,5 uur tussen gelijkwaardigen.

Wat het meeste opvalt is hoe weinig Altman zegt over de echt enge kanten van AI. We hebben geen idee hoeveel mensen en bedrijven op dit moment werken aan het bouwen van AI-modellen. Maar het zijn er tientallen, honderden, duizenden. Hoe ziet een Islamitische AI er uit? Een Russische? Een Israelische? Een … Chinese? Mensen met slechte bedoelingen zullen hun eigen AI ontwikkelen; misschien aan het werk zetten om disinformatie te verspreiden. Op zijn minst.

Altman heeft geen idee hoe dit onder controle te houden.

Ze praten veel over het andere risico: dat de AI al lerende zich ontwikkelt tot een Artificial General Intelligence (AGI), oftewel een ‘computer’ die slimmer is dan wij, met het risico dat die de mensheid zal uitroeien of knechten. Kunnen we waarborgen dat deze AGI, als hij komt, zal handelen in het belang van de mensheid? Hoe doe je dat? Ook hier heeft Altman geen antwoord op.

Het is fantastisch dat OpenAI zo’n ethisch bedrijf is. Wat een zegen! ‘Publiekelijk fouten maken,’ oftewel failing in public is de leidraad. Mensen laten meekijken. Twijfel is goed. Snel en toch behoedzaam werken: GTP-4 was al klaar vorige zomer, toch hebben ze dit wonder acht maanden voor zichzelf gehouden om te testen op zwakke plekken, voor de onthulling. OpenAI heeft een tweetraps bestuursstructuur waarin de beslissende stem wordt uitgebracht door een stichting zonder winstoogmerk. Dus geld is bij OpenAI geen drijfveer. Maar bij al die andere bedrijven ….

Een paar krenten:

‘Wij begrijpen niet altijd waarom het model dit doet, en niet dat.’ (00:13:33) Heeft GTP-4 kennis of wijsheid? ‘Door al deze kennis te absorberen komt hij op enig moment op een punt waar hij in staat is te redeneren’ (00:15:20)

Het is een verademing om te zien hoe GPT-4 nuance en evenwichtigheid in ere herstelt, zegt Fridman. Als je vraagt ‘Kwam Covid nu uit de natuur of uit een laboratorium?’ dan somt hij alle theorieën voor het een en het ander op, weegt ze op hun merites, en concludeert dat noch de ene, noch de andere stelling veel direct bewijs heeft. (1:52:50)

Heeft een AGI een lichaam nodig, om menselijke intelligentie te kunnen evenaren? (01:10:30)

(ook te beluisteren als podcast, zoek Lex Fridman)